Batch что такое: Что такое batch? Эпоха, батч, итерация – в чем различия? Руководство

Содержание

Что такое batch? Эпоха, батч, итерация – в чем различия? Руководство

Если вы ищете, что такое batch, эпоха и итерация, тогда скорее всего вы наконец-то решились изучать нейронные сети, потому что все эти понятия тесно связаны с обучением нейронных сетей.

Обучение нейронных сетей — это та еще задача. Возьмем самый простой пример. Допустим у вас есть изображения домашних животных и вы хотите научить нейронную сеть распознавать кошку и собаку. Если бы вы обучали человека распознавать этих животных, то процесс обучения у вас занял бы всего несколько минут. Люди сразу «схватывают» комплексные различия между разными видами животных, не вдаваясь в подробности, как они их различают. С нейронной сетью так не работает.

Нейронные сети — это программы, которые состоят из множества алгоритмов. Алгоритмы отвечают за распознавание конкретных свойств входных данных. Причем все эти свойства конвертированы в цифровой мир.

То есть нейронной сети нельзя просто показать две фотографии и сказать: «Вот это кошка, а вот это собака». Им нужно «объяснить», почему кошка — это кошка, а собака — это собака. Причем не просто «объяснить», а показать на конкретные свойства, которые отличают кошек от собак. Таких свойств может быть сотни и даже тысячи.

Мы не будем сегодня подробно расписывать работу нейронных сетей, но разберем термины батч, эпоха и итерация, которые тесно связаны с их обучением.

Что такое batch (батч), эпоха и итерация?

При обучении нейронных сетей постоянно используется поток обучающих входных данных. Нейросеть проводит вычисления с этими данными. Она это делает снова и снова, опираясь на предыдущие знания и выискивая новые свойства для самообучения. Например, на предыдущем потоке данных нейросеть выяснила, что кошки от собак очень часто отличаются по форме тела, поэтому теперь она понимает, что если на фото изображено большое животное, то скорее всего это не кошка.

На нынешнем потоке входных данных нейросеть выяснила, что у собак чаще всего мордочка более продолговата, чем у кошек, поэтому если на изображении у животного продолговатая мордочка, то скорее всего это собака. Пока не будем разбирать исключения типа собак с приплюснутой мордочкой или размером с кошку. В этих случаях сработают другие признаки, по которым нейросеть различит кошку от собаки.

Что такое эпоха?

Эпоха — это большой обучающий цикл, который состоит из большого набора входных данных. Например, после окончания первой эпохи, нейронная сеть научилась различать кошек и собак по:

- размеру и форме тела;

- форме мордочки;

- характерной окраске;

- форме хвоста.

Обычно процесс обучения нейронной сети состоит из нескольких эпох. После прохождения эпохи обучения, нейронная сеть уже выдает положительную динамику в обучении. Например, после первой эпохи, мы научили нейронную сеть различать кошек и собак по 4 признакам, которые мы описали чуть выше.

В результате получаем, что нейросеть корректно распознает этих животных в 60% случаев, в 40% все-таки ошибается. Вроде бы результат уже есть, но не тот, который бы нас устраивал. Тогда можно создать еще одну эпоху обучения и добавить еще несколько признаков, по которым можно различить кошек и собак, например по:

- форме лап;

- форме ушей;

- форме глаз;

- форме усов на мордочке.

После окончания этой эпохи обучения, нейронная сеть начала корректно распознавать кошек и собак в 80% случаев, потому что распознает уже не по 4 признакам, а по 8.

Все цифры условные, но смысл должен быть понятен, что такое эпоха. Важно отметить, что в определенный момент количество эпох не влияет на качество обучения нейронной сети. То есть утверждать, что обучение в 10 эпох лучше, чем обучение в 5 эпох — это неправильно. Плюс, при обучении нейронной сети есть такое понятие, как «переобучение», о котором мы поговорим в отдельной статье.

Что такое итерация?

Мы выяснили, что эпоха — это некий этап обучения, который состоит из большого объема данных. Например, в нашем случае в течение одной эпохи мы учим нейронную сеть различать кошек и собак по 4 признакам.

Однако, если разобрать процесс обучения нейросети в масштабе одной эпохи, то мы заметим, что мы не даем нейронной сети сразу весь пакет данных и пытаемся ее обучить сразу четырем признакам. Эпоха разбивается на несколько частей или этапов. В нашем случае логично эпоху разбить на 4 пакета по количеству признаков отличия кошек и собак.

Итерация — это «прохождение», этап, пакет, из которых состоит одна эпоха. То есть, в нашем случае, наша эпоха состоит из 4 итераций. В одной итерации мы обучаем нейронную сеть различать кошек и собак по одному признаку.

Что такое батч?

Батч — это составная часть итерации. Условно, мы имеем одну итерацию, в которой хотим обучить нейронную сеть отличать кошек и собак по размеру и форме тела.

Для этого процесса мы подготовили 100 тысяч изображений. То есть, после того как нейронная сеть изучит эти изображения, закончится первая итерация первой эпохи.

Если рассмотреть этот вопрос подробнее, тогда мы увидим, что в процессе одной итерации мы не выгружаем сразу все 100 тысяч изображений в нейронную сеть, а разбиваем их нелогические части. Например, в одной части итерации мы будем обучать нейросеть различать высоту тела животного, в другой части длину тела животного, в третьей — расположение головы и др. Все это относится к форме тела животного, но все же — это разные признаки. Таких признаков может быть очень много. Условно, в процессе этой итерации мы определили 10 таких признаков, и на каждый признак выделили по 10 тысяч изображений.

Батч — это небольшой пакет данных одной итерации. В нашем примере, одна итерация в 100 тысяч фотографий будет состоять из 10 батчей по 10 тысяч изображений.

Заключение

Изучение нейронных сетей — это очень обширная тема.

Сегодня мы изучили только, что такое батч, итерация и эпоха. Эти три термина тесно связаны с процессом обучения нейронных сетей.

Эпоха, батч, итерация — в чем различия?

Вам должны быть знакомы моменты, когда вы смотрите на код и удивляетесь: “Почему я использую в коде эти три параметра, в чем отличие между ними?”. И это неспроста, так как параметры выглядят очень похожими.

Epoch - Batch Size - Iteration

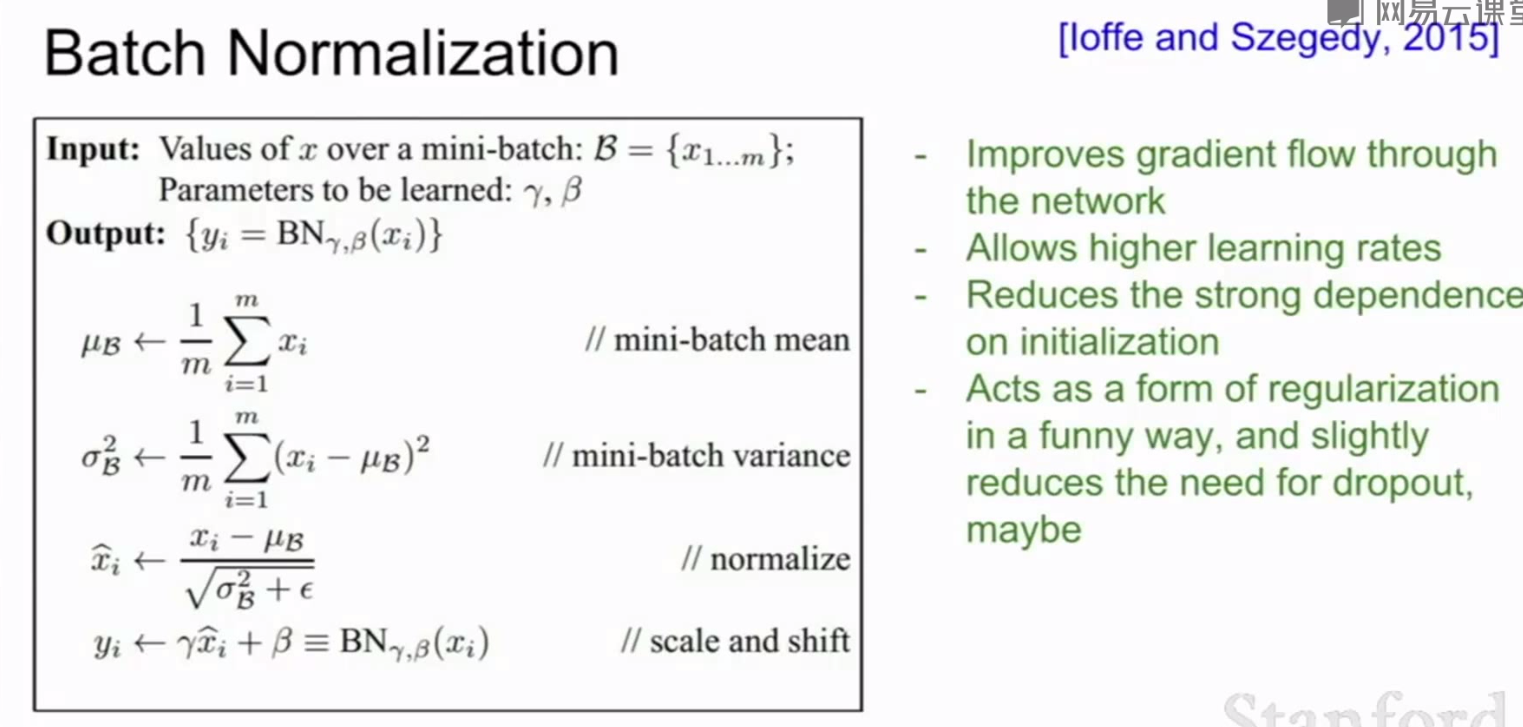

Чтобы выяснить разницу между этими параметрами, требуется понимание простых понятий, таких как градиентный спуск.

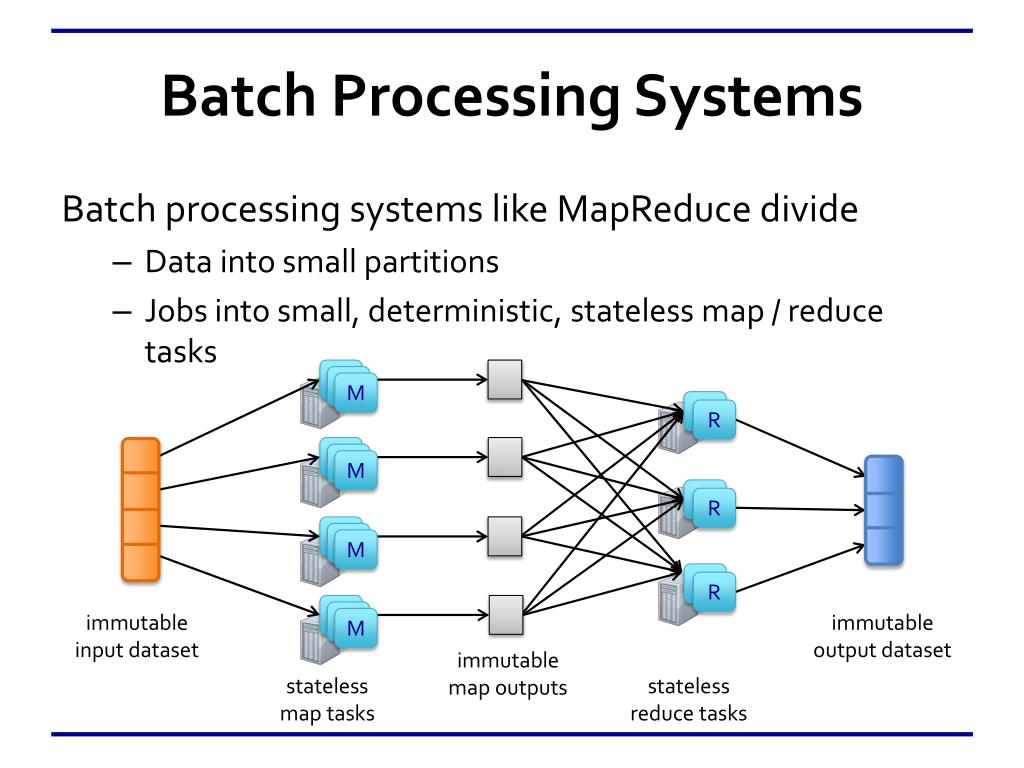

Градиентный спуск

Это ни что иное, как алгоритм итеративной оптимизации, используемый в машинном обучении для получения более точного результата (то есть поиск минимума кривой или многомерной поверхности).

Градиент показывает скорость убывания или возрастания функции.

Спуск говорит о том, что мы имеем дело с убыванием.

Алгоритм итеративный, процедура проводится несколько раз, чтобы добиться оптимального результата. При правильной реализации алгоритма, на каждом шаге результат получается лучше. Таким образом, итеративный характер градиентного спуска помогает плохо обученной модели оптимально подстроиться под данные.

При правильной реализации алгоритма, на каждом шаге результат получается лучше. Таким образом, итеративный характер градиентного спуска помогает плохо обученной модели оптимально подстроиться под данные.

У градиентного спуска есть параметр, называемый скоростью обучения. На левой верхней картинке видно, что в самом начале шаги больше, то есть скорость обучения выше, а по мере приближения точек к краю кривой скорость обучения становится меньше благодаря уменьшению размера шагов. Кроме того, значение функции потерь (Cost function) уменьшается, или просто говорят, что потери уменьшаются. Часто люди называют функцию потерь Loss-функцией или просто «Лосс». Важно, что если Cost/Loss функция уменьшается, то это хорошо.

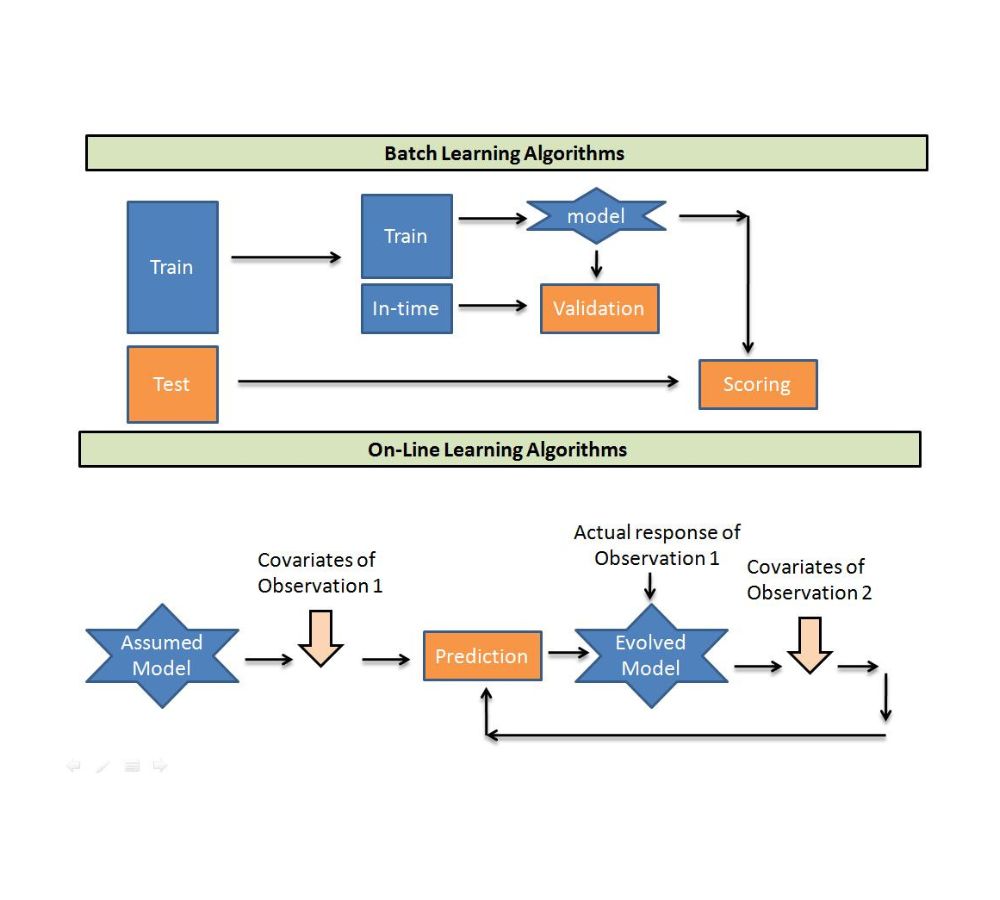

Как происходит обучение сети

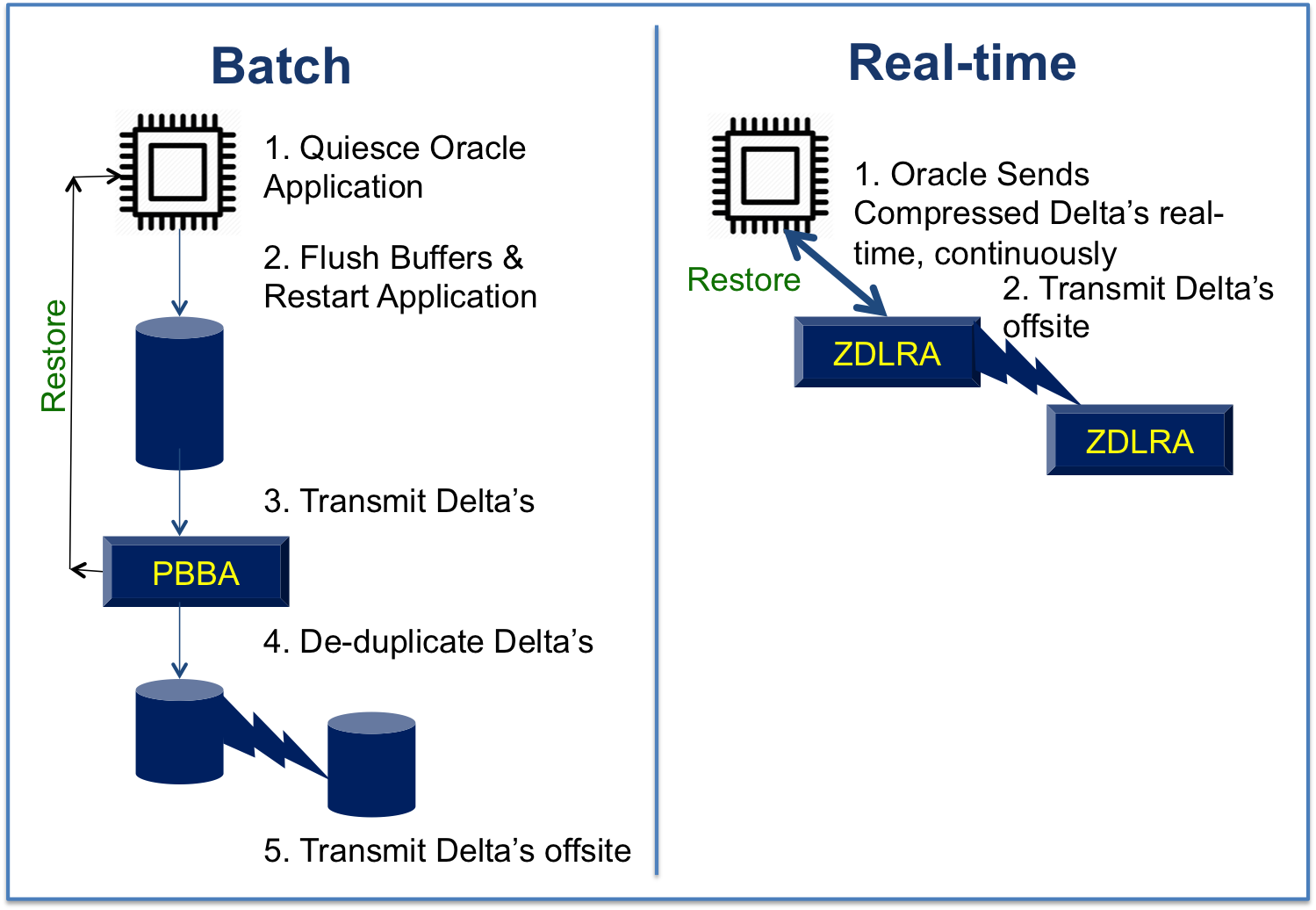

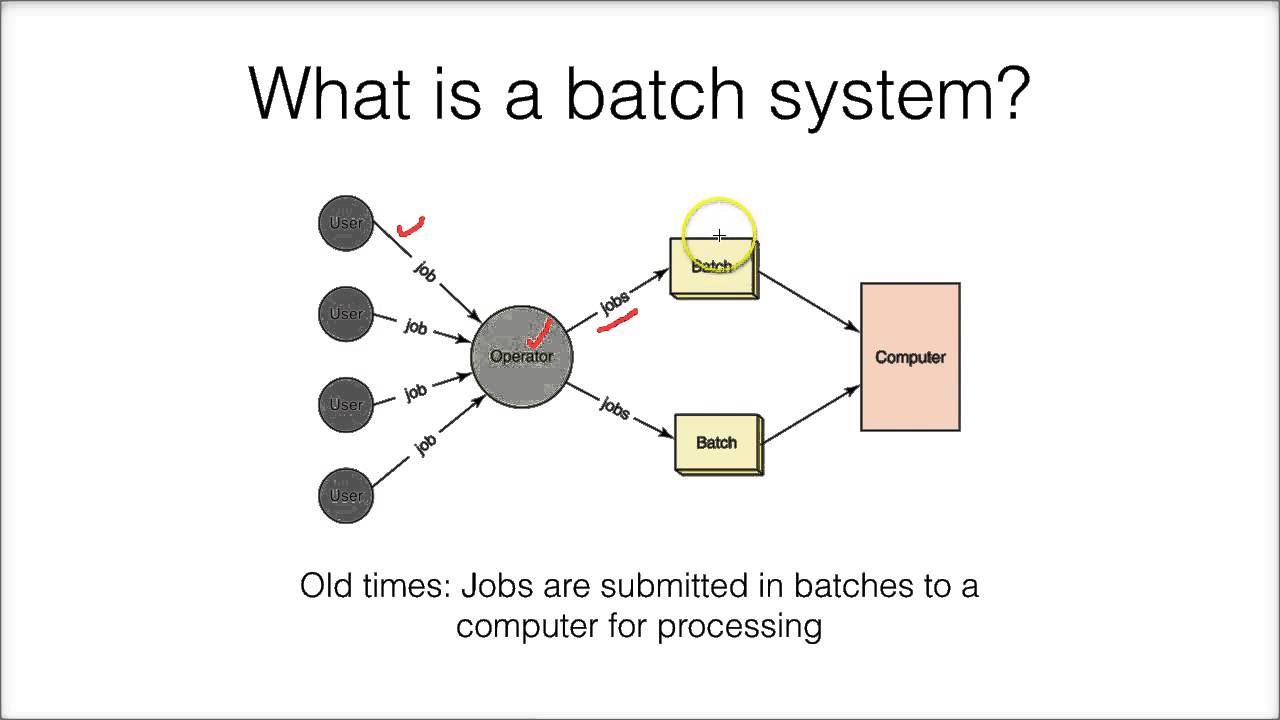

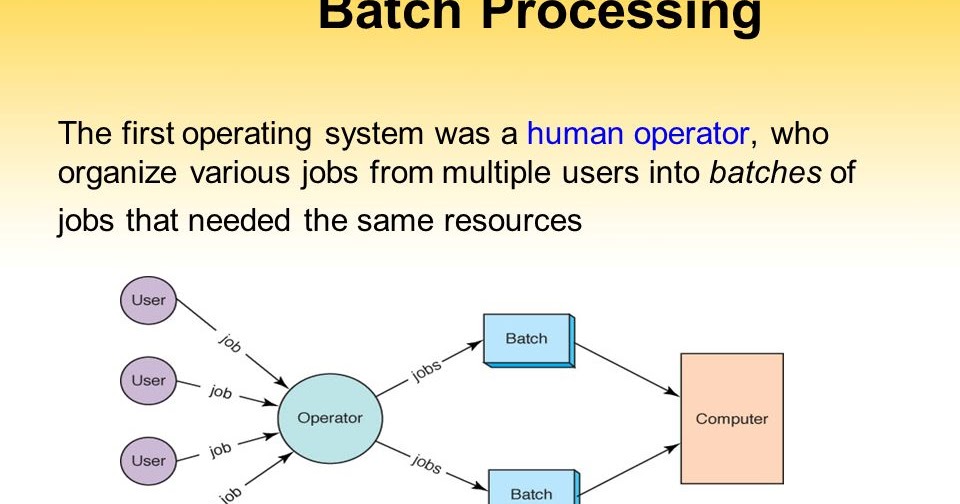

Исследователи работают с гиганскими объемами данных, которые требуют соответствующих затрат ресурсов и времени. Чтобы эффективно работать с большими объемами данных, требуется использовать параметры (epoch, batch size, итерации), так как зачастую нет возможности загрузить сразу все данные в обработку.

Для преодоления этой проблемы, данные делят на части меньшего размера, загружают их по очереди и обновляют веса нейросети в конце каждого шага, подстраивая их под данные.

Epochs

Произошла одна эпоха (epoch) — весь датасет прошел через нейронную сеть в прямом и обратном направлении только один раз.

Так как одна эпоха слишком велика для используемой вычислительной мощности, датасет делят на маленькие партии — батчи.

Почему мы используем более одной эпохи

Вначале не понятно, почему недостаточно одного полного прохода датасета через нейронную сеть, и почему необходимо пускать полный датасет по сети несколько раз.

Нужно помнить, что мы используем ограниченный датасет, чтобы оптимизировать обучение и подстроить кривую под данные. Делается это с помощью градиентного спуска — итеративного процесса. Поэтому обновления весов после одного прохождения недостаточно.

Одна эпоха приводит к недообучению, а избыток эпох — к переобучению:

С увеличением числа эпох, веса нейронной сети изменяются все большее количество раз. Кривая с каждый разом лучше подстраивается под данные, переходя последовательно из плохо обученного состояния (последний график) в оптимальное (центральный график). Если вовремя не остановиться, то может произойти переобучение (первый график) — когда кривая очень точно подстроилась под точки, а обобщающая способность исчезла.

Кривая с каждый разом лучше подстраивается под данные, переходя последовательно из плохо обученного состояния (последний график) в оптимальное (центральный график). Если вовремя не остановиться, то может произойти переобучение (первый график) — когда кривая очень точно подстроилась под точки, а обобщающая способность исчезла.

Какое количество эпох правильное?

На этот вопрос нет единственного точного ответа. Для различных датасетов оптимальное количество эпох будет отличаться. Но ясно, что количество эпох связано с разнообразием в данных. Например, в вашем датасете присутствуют только черные котики? Или это более разнообразный датасет?

Batch Size в нейронных сетях

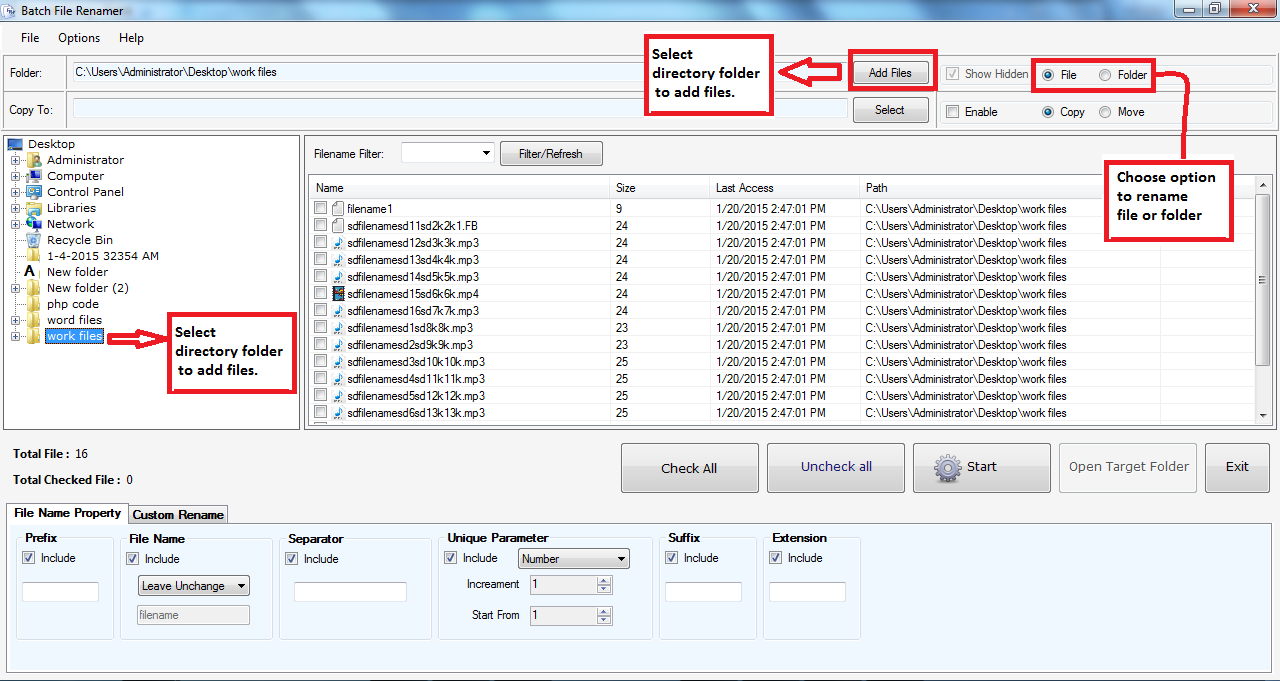

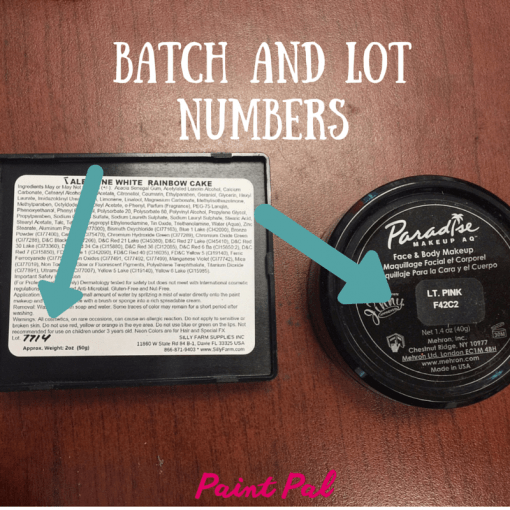

Размер батча — это общее число тренировочных объектов, представленных в одном батче.

Отметим: Размер батча и число батчей — два разных параметра.

Что такое батч?

Нельзя пропустить через нейронную сеть разом весь датасет. Поэтому делим данные на пакеты, сеты или партии, так же, как большая статья делится на много разделов — введение, градиентный спуск, эпохи, Batch size и итерации. Такое разбиение позволяет легче прочитать и понять статью.

Поэтому делим данные на пакеты, сеты или партии, так же, как большая статья делится на много разделов — введение, градиентный спуск, эпохи, Batch size и итерации. Такое разбиение позволяет легче прочитать и понять статью.

Итерации

Итерации — число батчей, необходимых для завершения одной эпохи.

Отметим: число батчей равно числу итераций для одной эпохи.

Например, собираемся использовать 2000 тренировочных объектов.

Можно разделить полный датасет из 2000 объектов на батчи размером 500 объектов. Таким образом, для завершения одной эпохи потребуется 4 итерации.

Получились следующие параметры:

Batch size = 500 Iterations = 4 Epoch = 1

Пакетное определение и значение — Merriam-Webster

1 из 3

ˈbach

1

: количество выпекаемых за один раз : выпечка

2

а

: количество материала, подготовленного или необходимого для одной операции

конкретно

: смесь сырьевых материалов, готовая к переплавке в стекло

б

: количество, произведенное за одну операцию

с

: группа работ (таких как программы), которые представляются для обработки на компьютере и результаты которых получены позднее

пакетная обработка

сравнение с разделением времени

3

: количество (людей или вещей), рассматриваемое как группа

пакет

2 из 3

переходный глагол

: собирать или обрабатывать в виде партии

дозатор

сущ.

партия

3 из 3

менее распространенное написание

bach

непереходный глагол

: жить холостяком

— часто используется с it

Синонимы

Существительное

900 80

Просмотреть все синонимы и антонимы в тезаурусе

Примеры предложений

Существительное

Мы испекли две партии печенья.

свежая партия сальсы

смешать еще партия цемента

Они нанимают еще партии рабочих.

Последние примеры в Интернете

Их собирают, а затем выпекают в большой партии на противне, чтобы обеспечить быстрое приготовление и большое количество порций — высокую стопку теплых бутербродов для собравшейся группы.

— Южные живущие редакторы, Южная жизнь , 12 июля 2023 г.

Франциск назвал девять партии новых кардиналов за 10 лет своего папства.

— Фрэнсис Д’Эмилио, BostonGlobe.com , 9 июля 2023 г.

Франциск назвал многочисленные партии новых кардиналов за свое 10-летнее папство.

—Рейтер, NBC News , 9 июля 2023 г.

С 2017 года дополнительные партия стала рутинной, демонстрируя спрос, превышающий установленный десятилетиями лимит.

—Арселия Мартин, Dallas News , 9 июля 2023 г.

Первая партия зарядных станций NACS, которые могут использовать водители Mercedes и других производителей. откроется в конце этого года, говорится в сообщении компании.

— Кристофер Дж. Брукс, CBS News , 7 июля 2023 г.

Другой взорвал партия ригатони в перфорированном воке, объятом пламенем.

— Мэтт Гулдинг, Путешествия + Отдых , 7 июля 2023 г.

Сегодня дети свободно гуляют по мирной деревне, а люди всех возрастов собираются по выходным на праздники, которые заканчиваются только тогда, когда тыквы оскребают дно коммунальных порций еды и питья.

— Эрика Пейдж, The Christian Science Monitor , 7 июля 2023 г.

Первые 9Власти заявили, что в конце прошлого месяца в Эванстоне было сообщено о партии 0073 комаров с положительным результатом на вирус.

— Шанзе Ахмад, Chicago Tribune , 15 июня 2023 г.

Они также предназначены для обработки структурированных и неструктурированных данных, а также потоковой и пакетной обработки данных.

— Локеш Ананд, Forbes , 5 мая 2023 г.

Обладая рабочим объемом 219 на 123 на 210 мм в кубе, Saturn 8K предлагает достаточно места для печати больших моделей или партий деталей.

— Стефани Млот, PCMAG , 18 апреля 2023 г.

Есть советы, рецепты и инструкции не только по смешиванию напитков, но и о том, как держать домашнюю морозильную камеру с основными ингредиентами; комбинация из 12 бутылок, из которой можно приготовить 50 разных коктейлей; и как партия напитки заранее для званого обеда.

— Los Angeles Times , 4 ноября 2021 г.

Дополнения включают наборы для коктейлей и партии коктейлей.

— Холли Баумбах, chicagotribune.com , 15 июня 2021 г.

Система предлагала интерактивную обратную связь в то время, когда большая часть взаимодействия с компьютером была пакетной .

— Кэмерон Кайзер, 9 лет.0073 Ars Technica , 17 марта 2023 г.

Заказы комплектуются и упаковываются в магазинах, а затем перемещаются в центры сортировки для группировки по районам для доставки либо сторонним перевозчиком, либо водителем с Shipt.

— Лиз Янг, WSJ , 23 февраля 2023 г.

New Year 2023 Bourbon (SRP $89,99) продолжает превосходную серию Barrell Craft Spirits за последний год, следуя за новой смесью Vantage и высококачественными версиями Gold Label ласточкина хвоста и Seagrass, не говоря уже о партия 33 из основной линейки бурбона.

— Джона Фликер, Отчет Робба , 27 декабря 2022 г.

Не знаете, как правильно приготовить коктейли из ?

— Кирби Адамс, The Courier-Journal , 7 марта 2022 г.

Узнать больше

Эти примеры программно скомпилированы из различных онлайн-источников, чтобы проиллюстрировать текущее использование слова «пакет». Любые мнения, выраженные в примерах, не отражают точку зрения Merriam-Webster или ее редакторов. Отправьте нам отзыв об этих примерах.

Любые мнения, выраженные в примерах, не отражают точку зрения Merriam-Webster или ее редакторов. Отправьте нам отзыв об этих примерах.

История слов

Этимология

Существительное

среднеанглийский bache ; сродни древнеанглийскому bacan выпекать

Первое известное употребление

Существительное

15 век, в значении, определенном в значении 1

Глагол (1)

1863, в значении, определенном выше

900 02 Путешественник во времени

Первое известное использование партии было

в 15 веке

Посмотреть другие слова того же века

Словарные статьи рядом с

пакетом

летучая мышь

партия

пакетный файл

Посмотреть другие записи поблизости

Процитировать эту запись

«Партия.

» Словарь Merriam-Webster.com , Merriam-Webster, https://www.merriam-webster.com/dictionary/batch. По состоянию на 14 июля 2023 г.

» Словарь Merriam-Webster.com , Merriam-Webster, https://www.merriam-webster.com/dictionary/batch. По состоянию на 14 июля 2023 г.

Копировать ссылку

Детское определение

Пакет

сущ.

1

а

: количество, использованное или изготовленное за один раз

a партия печенья

б

: группа заданий, которые должны выполняться на компьютере одновременно с одной и той же программой.

партия обработка

2

: группа людей или вещей : партия

Еще от Merriam-Webster о партии

9 0077

Английский язык: перевод пакета для говорящих на испанском языке

Britannica Английский: перевод пакета для говорящих на арабском языке

Последнее обновление:

— Обновлены примеры предложений

Подпишитесь на крупнейший словарь Америки и получите тысячи дополнительных определений и расширенный поиск без рекламы!

Merriam-Webster без сокращений

Пакет Определение и значение | Dictionary.

com

com

- Игры

- Избранные

- Поп-культура

- Советы по написанию

[бах]

См. синонимы для: batchbatchesbatchesbatching на Thesaurus.com

сущ.

количество или число, поступающее одновременно или вместе взятые: группа заключенных.

количество материала, приготовленного или необходимого для одной операции: смешивание партии бетона.

количество хлеба, печенья, теста и т.п., приготовленное за одну выпечку.

Компьютеры.

Производство стекла.

глагол (используется с объектом)

для объединения, смешивания или обработки в пакете.

Происхождение партии

1

Впервые записано в 1425–1475 гг. ; позднесреднеанглийское bache «количество хлеба, производимое за одну выпечку», древнеанглийское gebæc; сродни немецкому Gebäck «выпечка, пирожные»; см. происхождение при выпечке

; позднесреднеанглийское bache «количество хлеба, производимое за одну выпечку», древнеанглийское gebæc; сродни немецкому Gebäck «выпечка, пирожные»; см. происхождение при выпечке

Другие слова для партии

| 1 | пучок, группа, партия, количество, набор; группа, стая, банда, стая, отряд |

См. синонимы для пакета на Thesaurus.com

Dictionary.com Unabridged

На основе Random House Unabridged Dictionary, © Random House, Inc. 2023

Как использовать пакет в предложении

Финляндия, Швеция и Норвегия попросили вспомнить эти конкретные пакеты, что мы и делаем.

Европейцы отзывают виски Fireball вместо подсластителя, также используемого в антифризе | Тим Мак | 28 октября 2014 г. | ЕЖЕДНЕВНОЕ ЗВЕРЬ

Единственный способ производить мороженое в этом магазине — ежедневно, вручную, небольшими партиями.

Доктор Майк делает лучшее мороженое на Земле | Джейн и Майкл Стерн | 27 июля 2014 г.

| THE DAILY BEAST

| THE DAILY BEASTВ течение трех месяцев прошлого года он проводил тренировки для партий молодых бойцов.

Самодельные истребители Боко Харам в Нигерии | Нина Строхлик | 16 мая 2014 г. | THE DAILY BEAST

Плохие партии героина также распространяются по всей стране.

Смертельный героин Филипа Сеймура Хоффмана «Пиковый туз» | Марлоу Стерн | 3 февраля 2014 г. | ЕЖЕДНЕВНОЕ ЗВЕРЬ

И один или два раза в неделю я буду заваривать три галлона чая со льдом и ставить его в холодильник.

Как я пишу: Майкл Коннелли | Ной Чарни | 8 января 2014 г. | ЕЖЕДНЕВНОЕ ЗВЕРЬ

Поначалу у нас были большие трудности с приготовлением хлеба, и несколько партий были очень «тяжелыми» неудачами.

Дом метели | Дуглас Моусон

Он перекинулся теперь от епископов и священников к самому народу, и страдальцы отправлялись на костер группами.

История английского народа | Джон Ричард Грин

Преследователи и шпионы выследили иезуитов, вытащили из их укрытий и группами отправили в Тауэр.

То есть нейронной сети нельзя просто показать две фотографии и сказать: «Вот это кошка, а вот это собака». Им нужно «объяснить», почему кошка — это кошка, а собака — это собака. Причем не просто «объяснить», а показать на конкретные свойства, которые отличают кошек от собак. Таких свойств может быть сотни и даже тысячи.

То есть нейронной сети нельзя просто показать две фотографии и сказать: «Вот это кошка, а вот это собака». Им нужно «объяснить», почему кошка — это кошка, а собака — это собака. Причем не просто «объяснить», а показать на конкретные свойства, которые отличают кошек от собак. Таких свойств может быть сотни и даже тысячи. На нынешнем потоке входных данных нейросеть выяснила, что у собак чаще всего мордочка более продолговата, чем у кошек, поэтому если на изображении у животного продолговатая мордочка, то скорее всего это собака. Пока не будем разбирать исключения типа собак с приплюснутой мордочкой или размером с кошку. В этих случаях сработают другие признаки, по которым нейросеть различит кошку от собаки.

На нынешнем потоке входных данных нейросеть выяснила, что у собак чаще всего мордочка более продолговата, чем у кошек, поэтому если на изображении у животного продолговатая мордочка, то скорее всего это собака. Пока не будем разбирать исключения типа собак с приплюснутой мордочкой или размером с кошку. В этих случаях сработают другие признаки, по которым нейросеть различит кошку от собаки. В результате получаем, что нейросеть корректно распознает этих животных в 60% случаев, в 40% все-таки ошибается. Вроде бы результат уже есть, но не тот, который бы нас устраивал. Тогда можно создать еще одну эпоху обучения и добавить еще несколько признаков, по которым можно различить кошек и собак, например по:

В результате получаем, что нейросеть корректно распознает этих животных в 60% случаев, в 40% все-таки ошибается. Вроде бы результат уже есть, но не тот, который бы нас устраивал. Тогда можно создать еще одну эпоху обучения и добавить еще несколько признаков, по которым можно различить кошек и собак, например по:

Для этого процесса мы подготовили 100 тысяч изображений. То есть, после того как нейронная сеть изучит эти изображения, закончится первая итерация первой эпохи.

Для этого процесса мы подготовили 100 тысяч изображений. То есть, после того как нейронная сеть изучит эти изображения, закончится первая итерация первой эпохи. Сегодня мы изучили только, что такое батч, итерация и эпоха. Эти три термина тесно связаны с процессом обучения нейронных сетей.

Сегодня мы изучили только, что такое батч, итерация и эпоха. Эти три термина тесно связаны с процессом обучения нейронных сетей. | THE DAILY BEAST

| THE DAILY BEAST